Technologie

On n’arrête pas le progrès, même dans la criminalité. Les escrocs et autres types de criminels ont désormais recours à ce que l’on pourrait qualifier d’arme : les “deepfakes”. Pour en savoir plus, nous vous invitons à lire cet article.

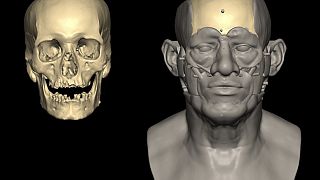

Des chercheurs se battent comme de beaux diables pour détecter les ‘‘deepfakes’‘. Il s’agit de vidéos truquées qui permettent à leurs auteurs de changer la voix d’un individu ou encore, de remplacer le visage d’une personne par une autre. Le tout, réalisé avec une dextérité hors pair qui pourrait même confondre certains experts en la matière.

Le phénomène s’avère réellement inquiétant dans la mesure où les auteurs de ces falsifications utilisent des techniques de plus en plus perfectionnées, faisant appel à une technologie de plus en plus à la portée du commun des mortels.

Les trucages autrefois basiques sont plus élaborés, l’intelligence artificielle ayant désormais fait son entrée en scène pour prêter main forte aux faussaires. A l‘époque, il s’agissait de manipuler soit la vidéo, soit l’audio. Mais les temps ont changé comme nous l’explique ici Vincent Nozick, maître de conférence à l’institut Gaspard Monge de l’Université Paris-Est Marne-la-Vallée :

Des actes de plus en plus audacieux

“Les manipulations peuvent toucher l’audio ou la vidéo. On est en train d’arriver à l’audio plus la vidéo. Je me demande ce qui va se passer pour les prochaines grandes élections. Pour créer un ‘deepfake’, la seule compétence requise est un peu d’expérience. Le premier sera a priori raté, car il faut choisir le bon modèle informatique (…) mais quelqu’un qui en a fait trois mois, c’est bon, il est prêt.”

Les exemples de ‘‘deepfakes’‘ sont décriés à la pelle. En 2017, des images de ce type ont été vues sur les forums du site web Reddit. Un utilisateur s’est amusé à partager des images truquées de films pornographiques avec pour actrices des célébrités féminines du 7e art qui, en réalité, n’ont rien à voir avec le monde du X. Pour ce film, les visages des actrices ont été manipulés. Le même genre de trucage a eu pour cible une journaliste et un député en Inde.

Si certains se contentent de s’amuser au détriment de leurs prochains, d’autres jouent la carte du vol. Le Wall Street Journal a rapporté fin août les ‘‘exploits’‘ d’escrocs qui ont imité la voix d’un PDG afin d’aboutir à un juteux transfert de fonds de pas moins de 220.000 euros. Le tout, avec l’appui de l’intelligence artificielle.

La Chine pour sa part vient de mettre sur pied Zao, une application qui permet de mettre son visage à la place d’un acteur dans un extrait de film. Il vous suffira de vous munir de quelques photos de vous et le tour est joué. Il est à noter que Zao est accessible au grand public.

Des universitaires Allemands ont eux opté pour la technique de la “marionettisation”. Depuis 2016, ils travaillent d’arrache-pied sur un logiciel qui consiste à ‘‘animer’‘ le visage d’une personnalité de sorte à lui imputer des paroles qu’elle n’a, en réalité, jamais prononcées. Cela pourrait permettre de produire de fausses conférences de presse que l’on pourrait attribuer à un chef d’Etat, entre autres. Le pire, c’est que cette entourloupe pourrait se produire… en direct.

Les célébrités constituent une cible de choix pour les auteurs de ‘‘deepfakes’‘, compte tenu de la facilité de s’approprier leurs images. Les spécialistes utilisent différentes techniques pour tenter de contrer la vague grandissante de ce nouveau type d’escrocs. Il s’agit par exemple de retrouver l’image originelle, celle créée avant la ‘‘deepfake’‘. Ainsi, les spécialistes pourront comparer la “signature gestuelle” habituelle de la personne visée., entre autres.

Contrer les auteurs de ‘‘deepfakes’‘

L’autre technique utilisée par les traqueurs de ‘‘deepfakes’‘ met l’accent sur les ratés du trucage lui-même. Exemples : l’incohérence dans le clignement des yeux, la disposition des cheveux ou encore, l’enchaînement jugé douteux des images. Mais les faussaires suivent le rythme et parviennent maintenant à effacer ce genre d’erreurs, s’approchant ainsi de la perfection.

Une nouvelle technique vient s’ajouter à la liste des stratégies de détection de vidéos et audio truqués : l’intelligence artificielle elle-même. De ce fait, des algorithmes d’IA (intelligence artificielle) sont réalisés dans l’unique but de défaire le bon grain de l’ivraie. Selon les chercheurs, les résultats sont plutôt positifs, mais la course contre la montre est d’actualité.

Vincent Nozick : “Un détecteur de ‘deepfake’ qui marchait bien il y a un an ne marchera pas forcément sur ceux de cette année.”

Ewa Kijak, maître de conférence à l’Université de Rennes 1, laboratoire Irisa, renchérit : “La machine peut percevoir des choses que nous ne voyons pas à l’œil nu, mais il faut qu’on ait des bases de données pour évaluer à quel point on peut être efficace. C’est ce qui manque actuellement.”

Google et Facebook, souvent pointés du doigt pour leur rôle présumé en termes d’intox, ont exprimé leur volonté d’aider à détecter les ‘‘deepfakes’‘. Pour cela, les deux géants du Web proposent de remettre à qui de droit les contrefaçons à leur disposition.

Décidés plus que jamais à faire mal, les auteurs des contrefaçons font appel à la technologie des “réseaux génératifs adverses” (GANs). Il s’agit ici pour eux de tester l’‘‘intraçabilité’‘ de leur travail. En clair, les contrefacteurs utilisent les GANs pour mieux masquer leurs méfaits en procédant à des tests.

Pour Ewa Kijak, la “mise à disposition d’outils de détection ne suffira pas”. Il faudra “une prise de conscience. Jusqu‘à présent, on pouvait avoir un peu plus confiance dans les vidéos. Maintenant, je pense que c’est terminé.”

Les ‘‘deepfakes’‘ pourraient constituer une arme redoutable entre les mains de terroristes et autres mafieux, décidés à se faire entendre dans un monde plus que jamais dominé par les NTIC (Nouvelles technologies de l’information et de la communication). Le défi étant lancé, c’est aux spécialises et gouvernements du monde entier de se mettre au travail.

11:17

Combler le fossé juridique dans le boom numérique de l'Afrique [Business Africa]

02:27

Des croix blanches alimentent des “fake news” sur la persécution d'Afrikaners

02:20

VivaTech 2025 : l'Afrique en pleine révolution technologique

01:52

VivaTech 2025 : une IA démasque les images retouchées par les influenceurs

Aller à la video

Insolite : la Chine organise le premier combat de boxe entre humanoïdes

01:17

USA : la Maison Blanche persiste et signe sur la persécution d'Afrikaners